Be Joyful!

코드스테이츠 PMB 10기 | Kaggle 데이터로 직접 알아보는 데이터 시각화의 중요성 본문

홍수다 홍수! 데이터의 홍수!

우리는 매일 자신도 모르는 새 디지털 세상에서 수많은 흔적들을 남기고, 수집하고, 또 서로 공유하고 있습니다. 그만큼 데이터와는 떼려야 뗼 수 없는 세상을 살아가고 있는데요. 이러한 데이터 홍수의 시대 속에서 데이터를 수집하고 축적하는 것도 중요하지만, 이를 관리하고 활용하는 능력이 더욱 필요해질 것입니다. 즉, 이제는 얼마나 많은 데이터를 수집하는가가 아니라, 데이터를 어떻게 활용할 것인가를 고민해야 하는 때입니다.

데이터의 양이 폭발적으로 증가하는 상황에서 누구나 알 수 있는 데이터를 나열하는 것은 의미가 없습니다. 데이터 경쟁력을 키우기 위해서는 수집한 데이터를 '분석'하고 '시각화'하여 더 많은 사람들과 인사이트를 공유할 수 있어야 합니다. 이러한 과정 속에서 PM은 핵심이 되는 데이터를 파악하고, 이에 집중하여 제품 개선에 활용할 수 있어야 할 것입니다.

오늘은 데이터를 활용하는 과정 중에서도, 데이터 분석 결과를 쉽게 이해할 수 있도록 시각적으로 표현하고 전달되는 과정을 일컫는 데이터 시각화(Data Visualization)에 대해 알아보고자 합니다.

데이터 시각화 (Data Visualization)

데이터 분석 결과를 쉽게 이해할 수 있도록 시각적으로 표현하고 전달되는 과정

PM에게 빼놓을 수 없는 중요한 역량 중 하나가 바로 데이터 분석 능력이라고 할 수 있습니다. PM에게 데이터 시각화가 중요한 이유는 시각화를 통해 분석과 결과 도출이 더욱 용이해 지며, 제품의 개선점을 보다 쉽게 발견할 수 있기 때문입니다. 이를 요약하자면 결국 PM에게 가장 중요한 역량인 분석과 커뮤니케이션을 위한 하나의 방법론이라고 볼 수 있겠습니다.

데이터 시각화 (Data Visualization)의 장점

- 데이터를 한눈에 볼 수 있다.

- 누구나 쉽게 시각화로 데이터 인사이트를 찾을 수 있다.

- 데이터에 대한 이해도를 높일 수 있다

- 데이터 인사이트를 공유하는 데 효과적이다.

- 다양한 분야에서 활용할 수 있다.

데이터 시각화 도구의 종류

데이터 시각화 도구는 우리가 잘 알고 있는 분석 툴인 구글 애널리틱스의 내장 대시보드부터, 시각화 전문 도구인 Tableau까지 그 종류도 다양합니다. 그래서 우리는 분석할 데이터의 종류와 중요도에 맞게 적절한 시각화 도구를 활용할 필요가 있습니다.

- 기존 분석 도구의 내장 대시보드 - Google Analytics, Amplitude 등

- 시각화 전문 도구 - Tableau 등

- 파이썬 용 시각화 라이브러리 - Matplotlib, seaborn 등

Kaggle 데이터를 활용하여 E-Commerce Data 분석해보기

캐글 (Kaggle)

오늘은 직접 데이터 시각화에 도전해보기 위해 Kaggle의 데이터를 활용했습니다. 수많은 데이터 중에서도 현재 우리 삶에서 떼려야 뗄 수 없게 되어버린, 그리고 현재 위클리 프로젝트로 다루고 있는 이커머스 플랫폼의 데이터를 분석해보고자 했습니다.

하여, Kaggle에서 찾은 인도 이커머스 사이트의 판매 내역 데이터를 활용해 나름의 가설을 세워보고, 데이터 시각화를 통해 수립한 가설을 직접 검증해보도록 하겠습니다.

.

.

<사용한 데이터>

https://www.kaggle.com/benroshan/ecommerce-data

E-Commerce Data

Sales details from Indian e-commerce website

www.kaggle.com

<데이터 포함 내역>

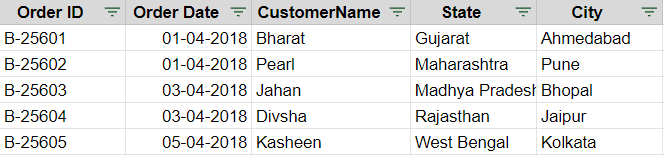

| List of Orders | ID, Date of Purchase, Customer details |

| Order Details | Order ID, Order price, Quantity, Profit, Category, Subcategory of Product |

| Sales target | Sales target amount, Date for each product category |

데이터 전처리

데이터 전처리 과정은 분석 및 활용을 위한 필수적인 과정입니다. 원하는 인사이트를 도출하기 위하여 데이터를 분석하기 좋게 가공하는 단계라고 볼 수 있습니다. 일반적으로 데이터 전처리는 <데이터 정제 - 결측값 처리 - 이상값 처리 - 분석변수 처리>의 순서로 진행됩니다.

저는 코(딩)알못인지라 아직 파이썬을 활용하기에는 어려움이 있었기에, 우선 가장 익숙한 구글 스프레드 시트를 이용해 데이터를 분석하고자 했습니다. 그리고 정석적인 데이터 전처리 과정은 아직 알지 못하기에, 우선 제가 원하는 데이터를 추출하기 좋게 변환하는 것에 초점을 맞춰 진행했습니다.

가장 먼저, 원하는 데이터를 추출하기 위해서 어떤 조치가 필요한지 확인하고자 각 시트의 구성을 확인했습니다.

위 두 테이블은 Order ID라는 동일한 키값을 가지고 있으며, 그 외 항목은 서로 중복되지 않습니다. 뒤에서 다시 언급하겠지만 제가 세운 가설을 검증하기 위해서는 지역별 매출액, 월별 매출액과 같은 데이터를 추출할 필요가 있습니다. 하여, 원하는 데이터를 추출하기 위해서는 두 시트를 병합해야 한다고 판단했습니다.

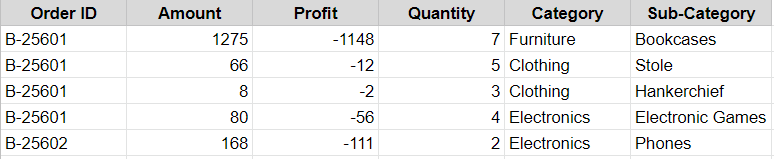

두 테이블을 병합하는 데는 여러가지 방법이 있겠으나, 저는 가장 익숙한 Vlookup 함수를 활용하고자 했습니다.

VLOOKUP (lookup_value, table_array, col_index_num, [range_lookup])

· lookup_value: 범위에서 원하는 값을 찾기 위한 키값

· table_array: 값을 찾을 범위

· col_index_num: 값을 찾을 범위에서 가져올 값이 있는 열의 위치

· range_lookup: 정확히 일치하는 키값을 찾을 것인지 근사값을 찾을 것인지 결정

(TRUE-근사값, FALSE-일치하는 값)

가장 먼저 시트 사본을 만들고, 기준이 되는 Order ID를 lookup_value로 설정하여 원하는 값을 불러올 수 있도록 수식을 작성했습니다. 위 이미지는 Vlookup 함수를 통해 Order ID를 기준으로 두 테이블이 성공적으로 병합된 모습입니다. 이제 이 데이터를 토대로 피벗 테이블을 활용해 원하는 데이터를 추출할 수 있습니다.

가설 수립 및 인사이트 도출

위 데이터를 바탕으로 다음과 가설을 수립하고, 매출 향상을 위한 인사이트를 도출해 보고자 합니다. 먼저 매출액 데이터를 통해 두 가지 가설을 수립하고 이를 검증하는 과정을 살펴보겠습니다.

가설1. 우기인 6 - 9월은 매출이 저조할 것이다.

가설2. 새해가 시작되는 1월에는 전자제품 매출이 상승할 것이다.

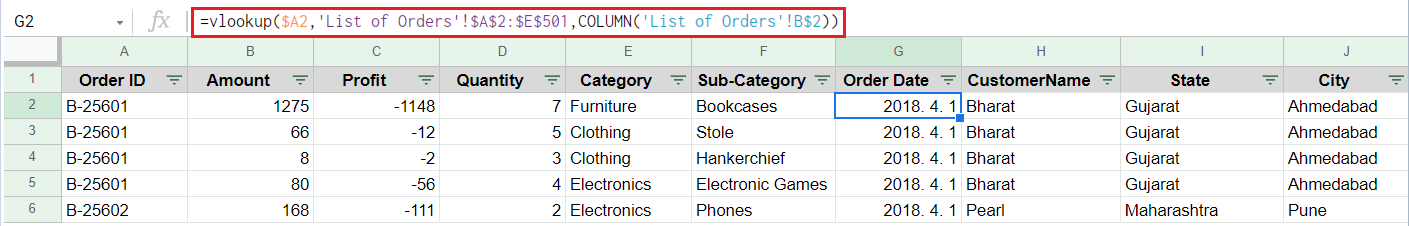

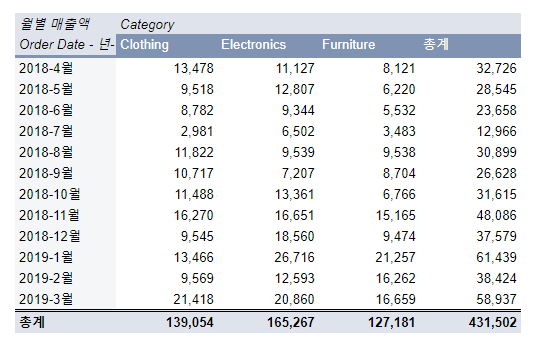

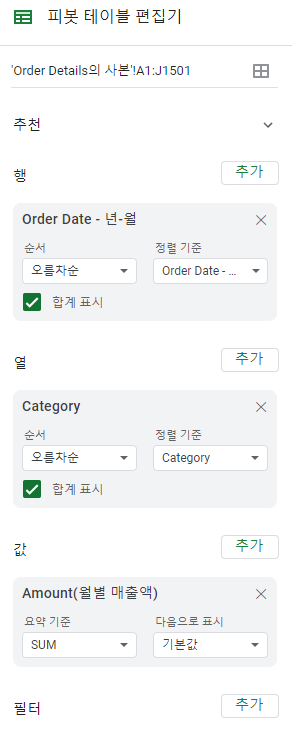

<Before: 피벗 테이블>

정제한 데이터를 바탕으로 월별 매출액을 확인하기 위해 피벗테이블을 이용한 모습입니다.

행: Order Date

열: Category

값: Amount 합계 기본값

(+ 월별 그룹화)

다음과 같은 설정을 통해 월별 매출액을 확인하고자 했습니다.

이러한 테이블 자료는 상세 수치를 확인하기에는 용이하겠으나, 매출액 추이를 한눈에 파악할 수 없어 인사이트를 도출하기에 어려움이 있습니다.

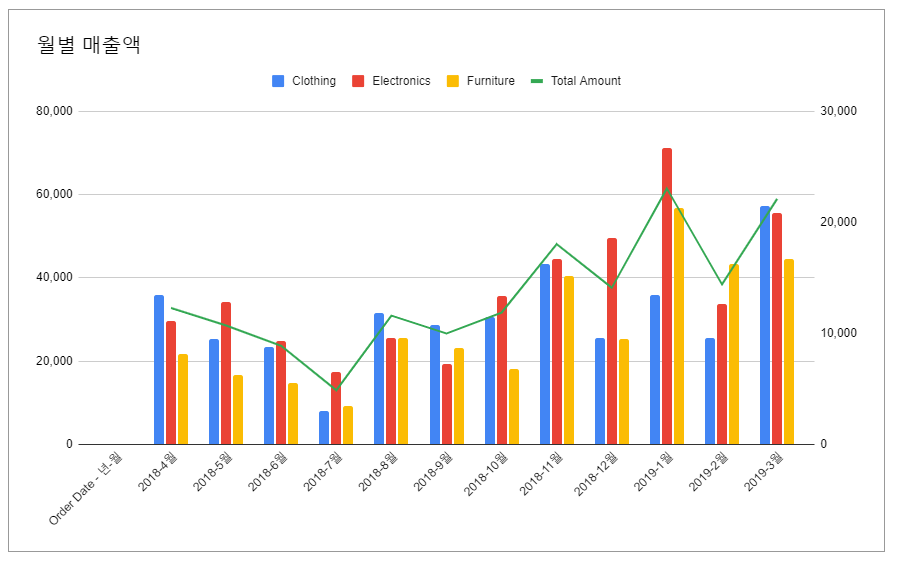

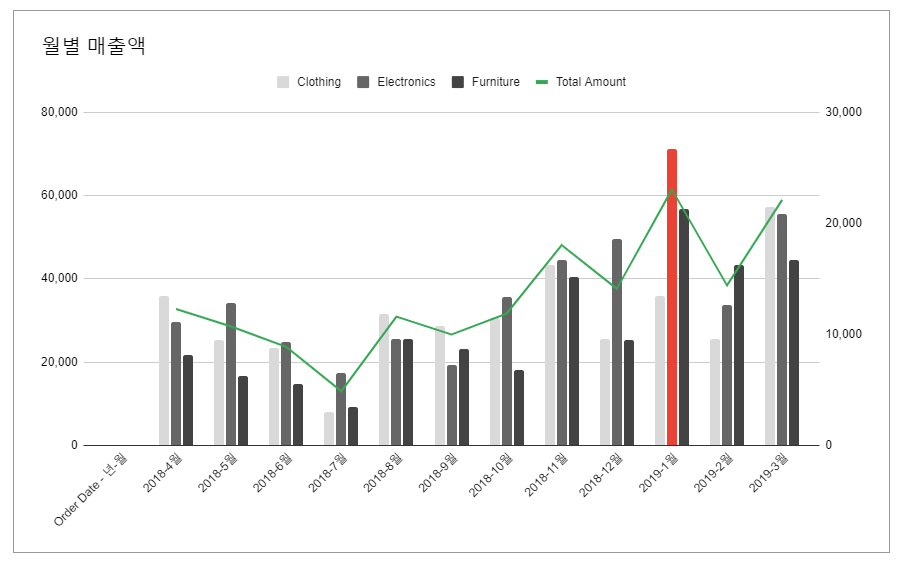

<After: 콤보 차트로 데이터 시각화>

위 데이터를 토대로 전체 월별 매출액 추이를 확인하고, 카테고리별 매출액을 비교하기 위해 콤보 차트를 활용했습니다.

더불어, 총액과 카테고리별 매출액의 금액 단위가 다르기 때문에 보조축을 추가하여 가시성을 높였습니다.

가설 1. 우기인 6 - 9월은 매출이 저조할 것이다.

제가 수집한 데이터는 인도의 이커머스 사이트의 주문내역이었습니다. 인도 소비자들의 구매 패턴을 추정하기 위해 계절적 특성을 확인했습니다. 인도는 몬순 기후의 영향으로 6-9월까지 우기에 해당하며, 이때 연 강수량의 대부분이 쏟아진다고 합니다. 이러한 특성을 반영해 해당 기간에는 데이터에 포함된 의류, 전자제품, 가구와 같은 품목에 대한 수요가 저조할 것으로 추정하여 가설을 수립했습니다.

차트로 확인해보니 실제로 해당 기간에 가까워질수록 매출액이 하락하고 있음을 알 수 있었으며, 본격적인 우기가 시작되는 7월에 매출이 가장 저조함을 확인했습니다. 분기별로 비교하더라도 우기에 해당하는 3분기의 매출액이 가장 낮다는 것을 알 수 있습니다.

한 가지 의문이었던 것은 7월에 비해 8월의 매출액이 다소 높다는 것이었습니다. 하여, 8월에 특별한 이슈가 있는지 확인해보고자 했습니다.

올해 기준 8월 일정을 확인해보니 2개의 축제와 독립기념일이라는 이슈가 있었습니다. 우기의 영향에도 불구하고 공휴일, 기념일 등의 이슈로 인해 소비가 진작되었음을 추정할 수 있습니다.

가설2. 새해가 시작되는 1월에는 전자제품 매출이 상승할 것이다.

새해, 새학기가 시작되는 1월에는 보통 주방 가전, 노트북 등 전자제품을 구매하고자 하는 수요가 증가합니다. 이러한 소비 패턴에 착안하여 위와 같은 가설을 세웠습니다.

그리고 다시 한 번 이전 차트를 확인한 결과 1월에는 모든 카테고리에서 매출이 향상되었으며, 그 중 Electronics의 비중이 가장 높음을 알 수 있습니다.

가설 1,2 검증 & 인사이트

이로써 가설 1,2에 대한 검증이 어느 정도 완료되었습니다. 이 내용을 바탕으로 아래와 같은 인사이트와 전략을 수립해보았습니다.

1. 계절적 영향에 따라 우기에는 소비 수요가 감소한다.

▶ 이에 대한 대응 전략으로는 상품 큐레이션을 제공하는 방법을 고안했습니다. 방수가 잘 되는 의류나 제습기와 같이 습한 환경에서 잘 활용할 수 있는 아이템들을 큐레이션하는 서비스가 있다면, 해당 기간에도 매출을 향상할 수 있을 것입니다.

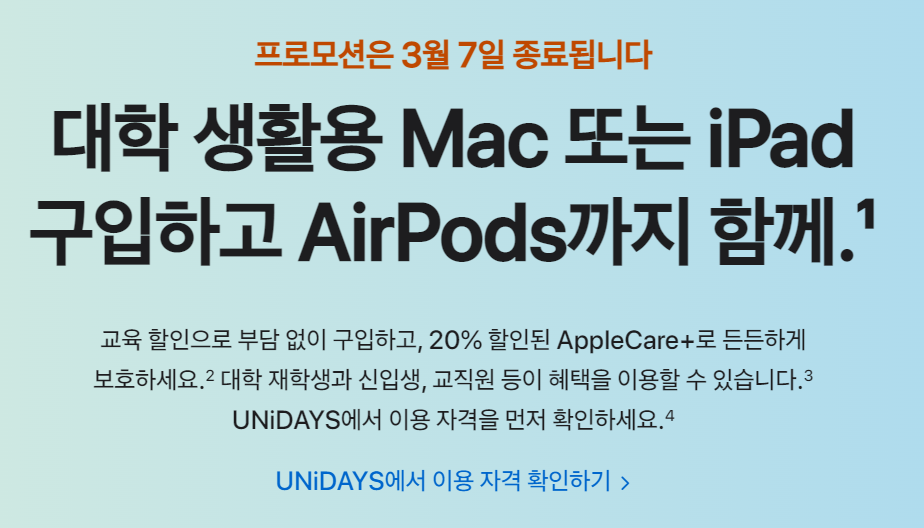

2. 1월에는 전체적으로 소비가 증가하며, 특히 전자제품의 매출이 높다.

▶ 전자제품 판매를 촉진하기 위한 기획전을 마련한다면 매출을 향상할 수 있을 것입니다. 유사한 사례로 애플에서 진행중인 교육 할인 프로모션이 있습니다. 기간 할인 프로모션뿐만 아니라, 구매 시 연관 상품을 추천하고 패키지로 구매할 경우 추가 할인 혜택을 제공하는 등 해당 기간동안 객단가를 향상하기 위한 다양한 전략을 마련할 수 있습니다.

가설 3. 소득이 높은 지역일수록 매출액 비중이 높을 것이다.

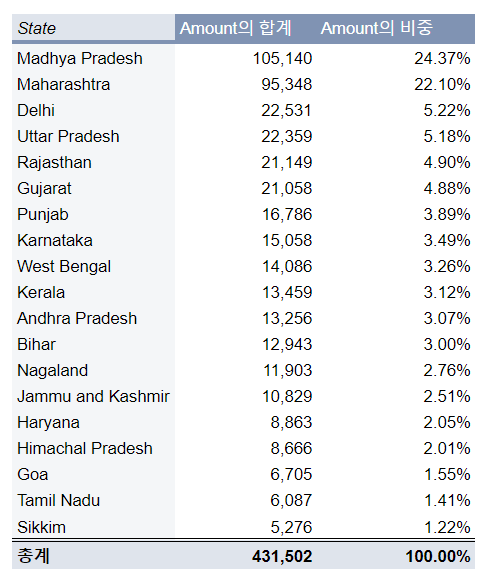

위 가설을 검증하기 위해서 다시 한 번 피벗테이블을 활용해 주(State)별 매출액을 확인하고자 했습니다.

<Before: 피벗 테이블>

지역별 매출액을 파악해야 하므로 다음과 같이 피벗 테이블 조건을 설정했습니다.

- 행: State

- 열1: Amount 합계의 기본값

- 열2: Amount 합계의 비중

그리고 수치를 파악하기 용이하도록 Amount 합계를 기준으로 내림차순 정렬 조건을 추가했습니다.

데이터를 보기 좋게 요약하니 해당 표로도 수치를 확인하는데 어려움은 없으나, 직관적으로 와닿지는 않는 것 같습니다.

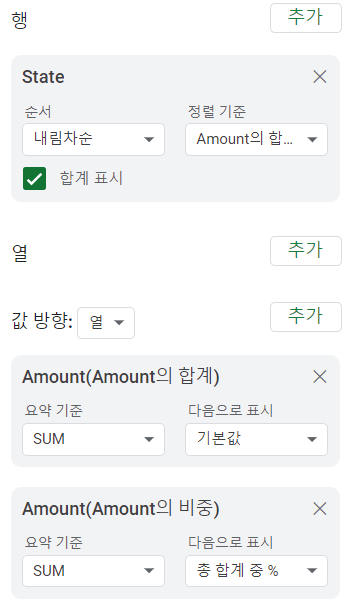

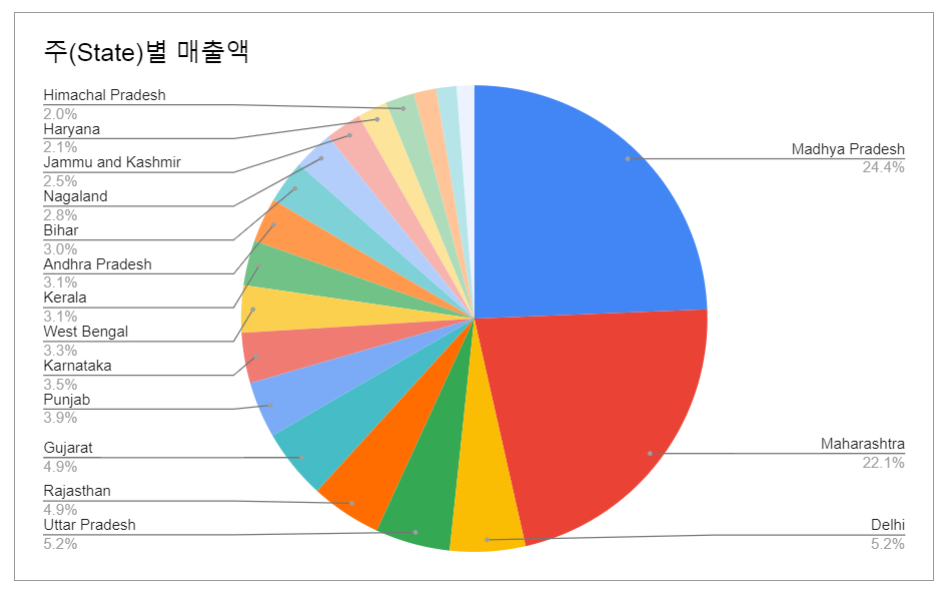

<After: 원형 차트로 시각화>

원형 차트는 변수가 하나일 경우 항목별 구성비를 나타낼때 유용하게 사용할 수 있습니다. 이렇게 데이터를 시각화하니 지역별 매출액 비중을 직관적으로 파악하기에 용이함을 알 수 있었습니다.

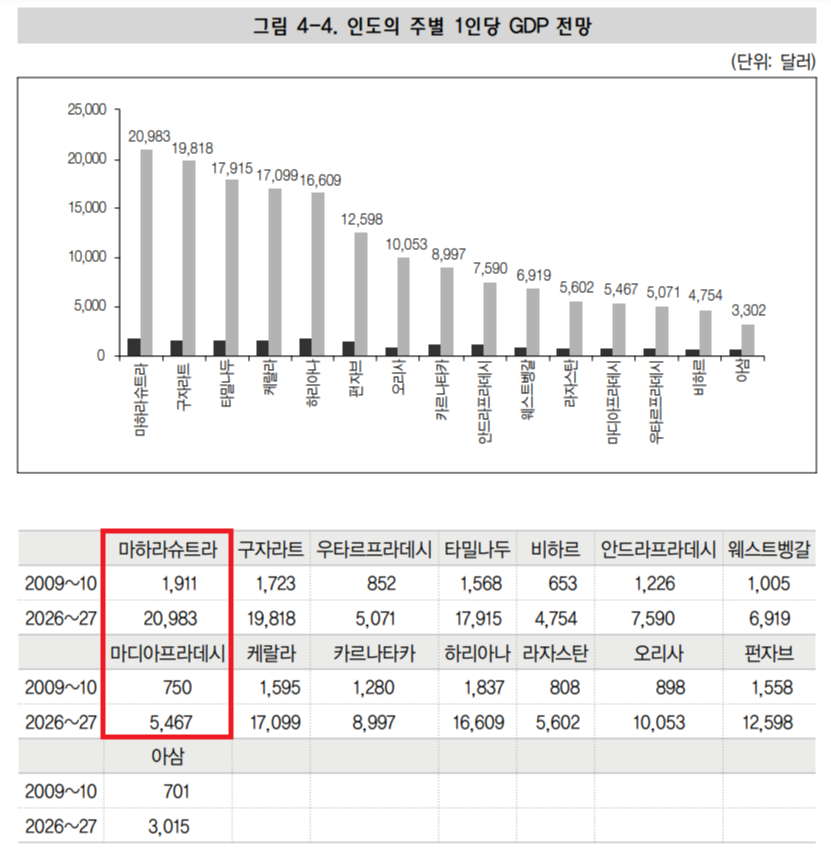

다만, 주어진 자료에는 주별 소득 수준을 파악할 수 있는 데이터가 없기 때문에, 가설 검증을 위해 대외경제정책연구원의 연구자료를 참고했습니다.

2018년 소득을 알 수 있는 자료는 찾을 수 없었기에, 2009~10년 수치를 참고하여 수치를 비교해봤습니다. 그 결과, 다음과 같이 데이터상의 매출액 1위 지역과 1인당 GDP가 가장 높은 지역은 일치하지 않음을 알 수 있었습니다.

- 매출액 1위 지역: 마디아프라데시

- 1인당 GDP 1위 지역: 마하라슈트라

결과적으로 지역별 소득은 매출액에 큰 영향을 미치지 않는다는 사실을 알 수 있었습니다.

오늘은 주어진 데이터를 시각화하고, 이를 통해 인사이트를 도출하는 과정을 연습해보고자 했다. 어떠한 목적을 가지고 직접 수집한 데이터가 아니기에, 이를 어떻게 활용하면 좋을지 고민하는 데에만 수시간이 걸린 것 같다. 우선은 가장 익숙한 구글 스프레드시트로 시각화를 해보았으나, 추후 구글 빅쿼리나 다른 시각화 도구를 활용해 분석하는 연습을 해봐야겠다. 데이터... 쉽지 않다! 하지만 무엇이든 처음엔 어려운 법! 뭐든 부딪치며 배우다보면 늘게 되어있어! 일단 해보자 퐈샤!

참고자료

https://newsjel.ly/archives/newsjelly-report/visualization-report/8136

당신도 데이터 시각화를 해야 하는 5가지 이유 - 뉴스젤리 : 데이터 시각화 전문 기업

데이터 활용 능력이 요구되는 시대, 왜 모두가 데이터 시각화를 해야 하는지 그 이유를 알아봅니다!

newsjel.ly

https://yssa.tistory.com/entry/Big-Data-%EB%8D%B0%EC%9D%B4%ED%84%B0-%EC%A0%84%EC%B2%98%EB%A6%AC

[Big Data] 데이터 전처리

데이터 전처리 데이터 분석 과정에서 데이터 전처리는 반드시 거쳐야 하는 과정 전처리 결과가 분석 결과에 직접적인 영향을 주고 있어서 반복적으로 수행함 데이터 분석의 단계 중 가장 많은

yssa.tistory.com

'PMB 10 Daily - 매일매일 성장기록' 카테고리의 다른 글

| 코드스테이츠 PMB 10기 | 하늘 아래 같은 앱은 없다. (2) | 2022.03.08 |

|---|---|

| 코드스테이츠 PMB 10기 | MBTI 과몰입 인간의 웹 개발 3대장 파헤치기 (6) | 2022.03.05 |

| 코드스테이츠 PMB 10기 | 린 분석으로 살펴보는 넷플릭스의 Next Step! (0) | 2022.03.01 |

| 코드스테이츠 PMB 10기 | GA도 다 무신사랑 해! (0) | 2022.02.25 |

| 코드스테이츠 PMB 10기 | 혼자 보고싶은 망고플레이트 데이터 분석 (0) | 2022.02.25 |